Seu cérebro com ChatGPT: uma análise profunda do débito cognitivo da IA

AIA pergunta central que este artigo se propõem a responder é: qual é o verdadeiro custo cognitivo de terceirizar nossas tarefas de pensamento para uma IA?

Nesse post eu resolvi destrinchar esse artigo do MIT que fez um certo alvoroço (de maneira superficial) no LinkedIn e entrar bem no detalhe de suas mais de 200 páginas para podermos falar de débito cognitivo causado pela IA.

A nova era da inteligência artificial e uma dívida silenciosa

"Uma vez, os homens entregaram seu pensamento às máquinas na esperança de que isso os libertaria. Mas isso apenas permitiu que outros homens com máquinas os escravizassem." - Frank Herbert, Duna, 1965

A citação de Frank Herbert, escrita décadas antes da nossa realidade digital, nunca foi tão relevante. Vivemos um momento de transformação monumental, impulsionado pela rápida proliferação de Modelos de Linguagem Grandes (LLMs). Ferramentas como o ChatGPT da OpenAI não são mais uma novidade de nicho; elas se integraram profundamente em nosso cotidiano, alterando a forma como trabalhamos, aprendemos e até pensamos. Para nós, profissionais de TI e programadores, que estamos na vanguarda da construção e utilização dessas tecnologias, o fascínio é ainda maior. As capacidades são impressionantes: personalização do aprendizado, feedback instantâneo e uma democratização sem precedentes do acesso à informação.

Contudo, sob a superfície dessa eficiência deslumbrante, uma questão crítica começa a emergir, levantada por pesquisadores do MIT em um estudo inovador intitulado "Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an Al Assistant for Essay Writing Task". A pergunta central que eles se propõem a responder é: qual é o verdadeiro custo cognitivo de terceirizar nossas tarefas de pensamento para uma IA?

Este artigo não é apenas mais um tutorial sobre como usar uma IA. É um mergulho profundo nas implicações neurológicas e comportamentais do uso de LLMs. Com base neste estudo rigoroso do MIT, vamos explorar como o cérebro humano reage quando usa assistentes de IA para uma tarefa cognitivamente exigente como a escrita. Vamos decodificar os dados de eletroencefalogramas (EEGs), analisar os padrões linguísticos e descobrir o que os pesquisadores chamam de "dívida cognitiva" – um fenômeno preocupante que sugere que a conveniência da IA pode estar nos custando nossas habilidades de pensamento crítico e aprendizado profundo. Para nós, que criamos e implementamos o futuro digital, compreender essas consequências não é apenas um exercício acadêmico; é uma responsabilidade fundamental.

Colocando o cérebro à prova

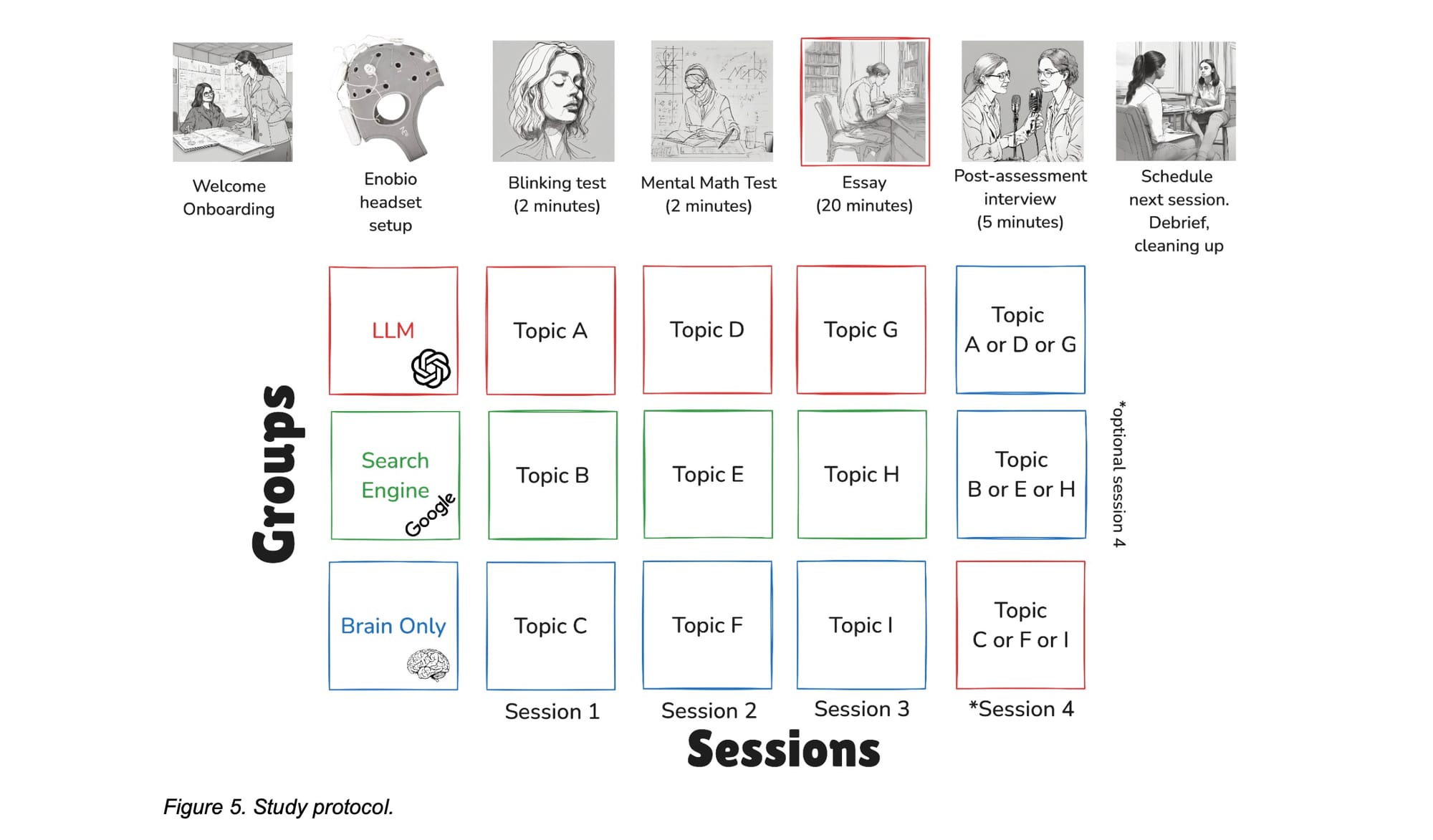

Para entender o impacto da IA no cérebro, os pesquisadores do MIT desenharam um experimento engenhoso e robusto. Eles recrutaram 54 participantes de renomadas universidades da área de Boston, como MIT, Harvard e Wellesley, e os dividiram em três grupos distintos para realizar uma tarefa comum, mas cognitivamente complexa: escrever uma redação no estilo do SAT (um exame educacional amplamente aplicado nos EUA).

Os três grupos foram designados da seguinte forma:

- Grupo LLM: Estes participantes podiam usar exclusivamente o GPT-4 da OpenAI como sua única fonte de informação e assistência. Nenhum outro navegador ou aplicativo era permitido.

- Grupo Mecanismo de Busca (Search Engine): Este grupo tinha a liberdade de usar a internet e qualquer mecanismo de busca (todos acabaram usando o Google), mas foram explicitamente proibidos de usar o ChatGPT ou qualquer outro LLM. Para garantir isso, os pesquisadores até adicionaram um filtro "-ai" nas buscas para evitar respostas aprimoradas por IA.

- Grupo Apenas Cérebro (Brain-only): Como o nome sugere, este grupo estava proibido de usar qualquer ferramenta externa. Eles contavam apenas com seu próprio conhecimento e capacidade de raciocínio para escrever a redação.

A tarefa consistia em escolher um de três temas de redação do SAT e escrever sobre ele por 20 minutos. Mas o que torna este estudo particularmente fascinante para nós, da área de tecnologia, é como a atividade cerebral foi medida. Durante todo o processo, os participantes usaram um headset de eletroencefalografia (EEG) com 32 eletrodos, o Enobio 32, para registrar seus sinais cerebrais em tempo real. Isso permitiu que os pesquisadores avaliassem o engajamento cognitivo, a carga de trabalho mental e os padrões de conectividade neural associados a cada método de escrita.

O experimento foi conduzido ao longo de quatro meses, com cada participante comparecendo a três sessões, mantendo-se sempre no mesmo grupo. A verdadeira sacada do estudo, no entanto, revelou-se na quarta sessão opcional. Nela, os grupos foram trocados: os participantes do grupo LLM foram convidados a escrever usando apenas seus cérebros (LLM-to-Brain), e os do grupo Apenas Cérebro receberam acesso ao LLM (Brain-to-LLM). Esta troca foi fundamental para observar os efeitos de longo prazo e a tal "dívida cognitiva".

O protocolo experimental, como ilustrado na Figura 5 do artigo, foi meticulosamente planejado, desde o onboarding e a calibração do EEG até a redação e uma entrevista pós-tarefa, garantindo a coleta de dados ricos e multifacetados.

Esta figura do artigo original mostra o fluxo do experimento. Cada participante passava por seis estágios:

- Boas-vindas e questionário.

- Configuração do headset de EEG.

- Teste de calibração (com tarefas como matemática mental).

- A tarefa principal de escrita da redação (20 minutos).

- Entrevista pós-avaliação.

- Debriefing e limpeza.

O estudo foi dividido em três sessões principais, com uma quarta sessão opcional. Em cada sessão, os participantes escolhiam um tópico de redação (Tópico A, B, C na Sessão 1, etc.). A Figura 5 deixa claro como os grupos (LLM, Search Engine, Brain Only) foram mantidos consistentes nas três primeiras sessões, com a troca ocorrendo apenas na sessão opcional, onde os participantes reescreviam sobre um tópico que já haviam abordado. Este design rigoroso permitiu uma comparação direta e profunda dos efeitos de cada ferramenta no processo cognitivo e no produto final.

Analisando a escrita

Além de olhar para dentro do cérebro com o EEG, os pesquisadores realizaram uma extensa análise de Processamento de Linguagem Natural (PNL) nas redações. Para nós, que trabalhamos com dados e algoritmos, esta parte do estudo é bem reveladora, pois quantifica as diferenças estilísticas (essa palavra existe? rs) e de conteúdo que muitas vezes sentimos intuitivamente ao ler um texto gerado por IA.

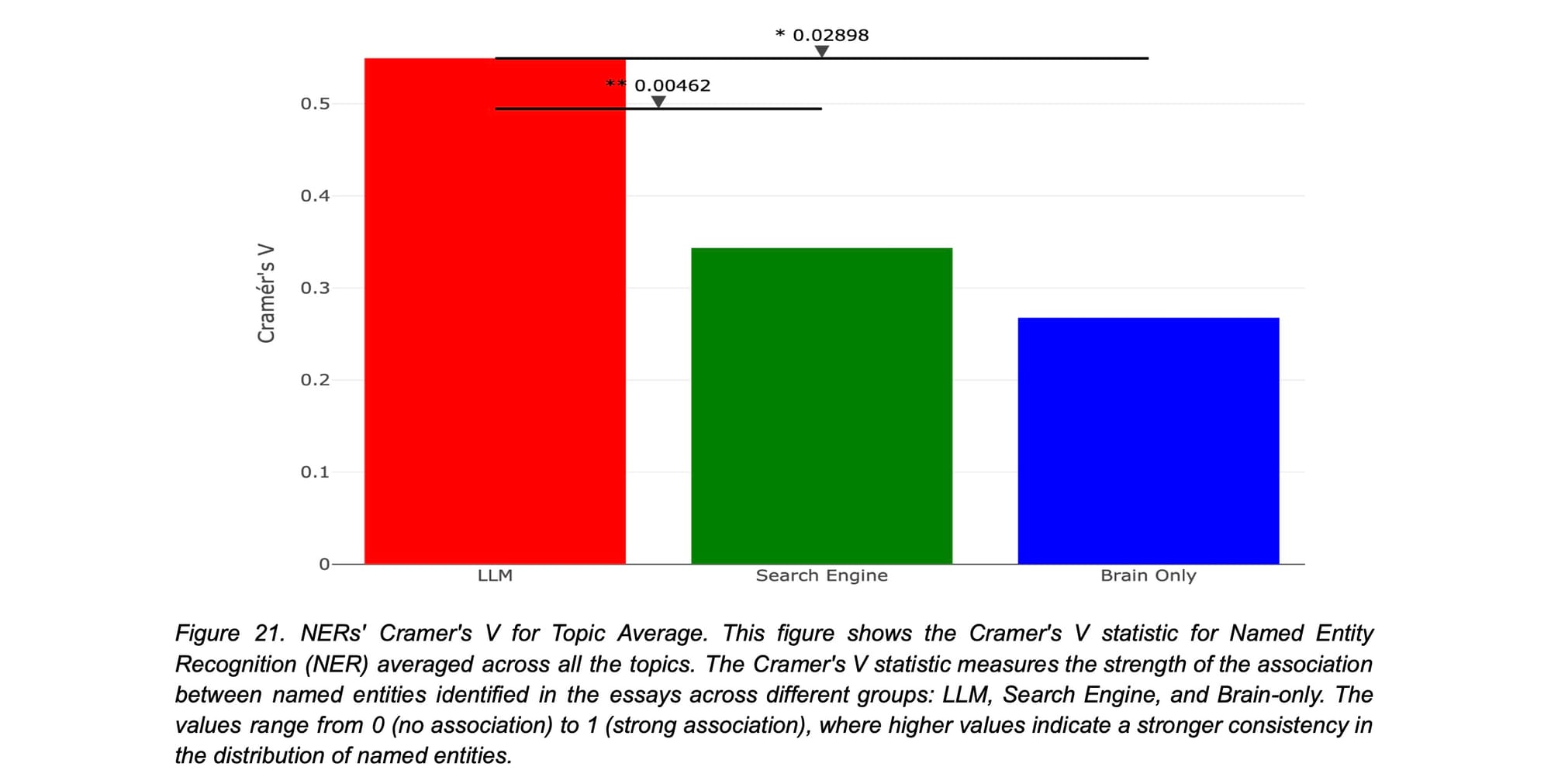

A homogeneidade da IA: entidades nomeadas (NERs)

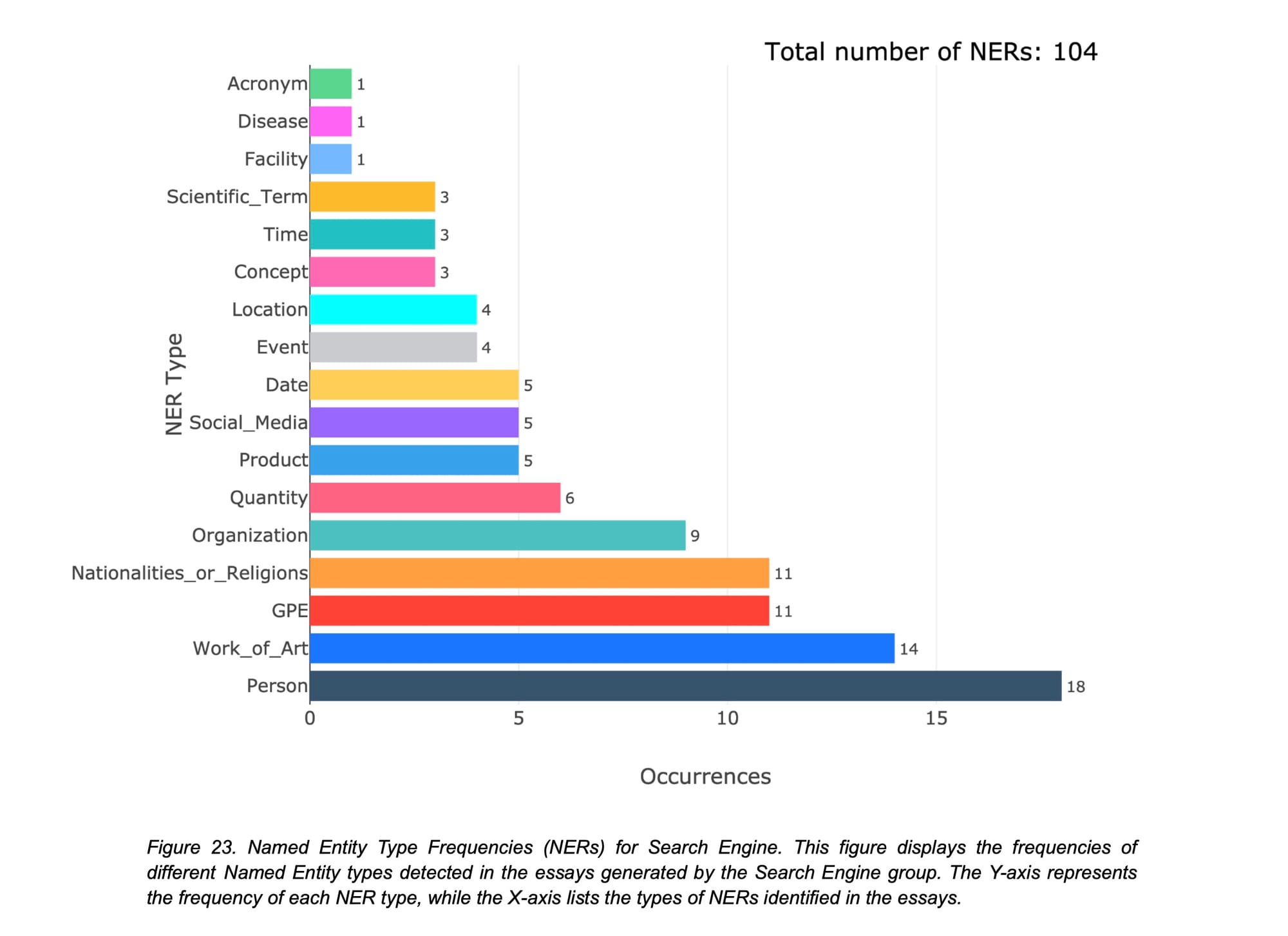

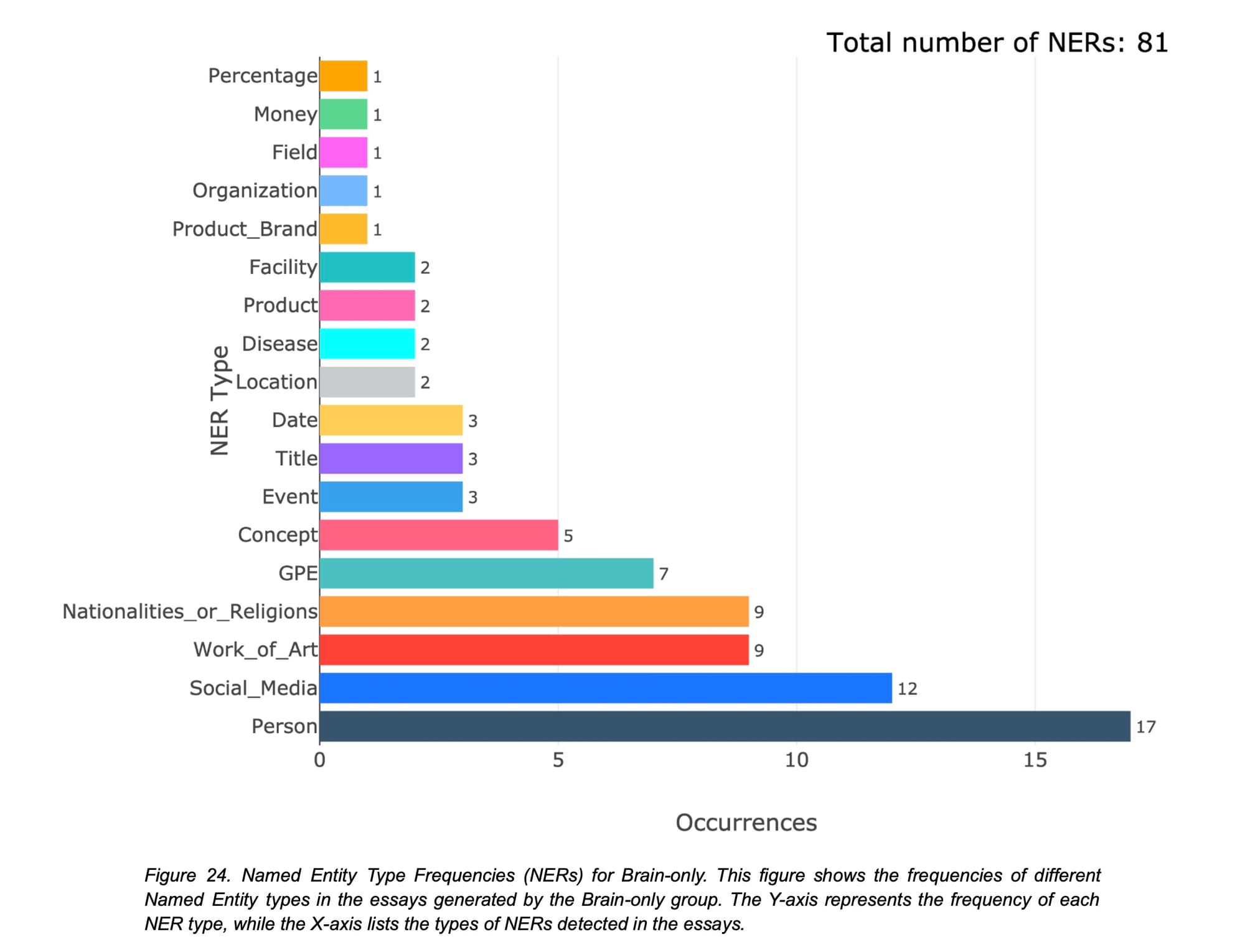

Um dos primeiros achados surpreendentes veio da análise de Reconhecimento de Entidades Nomeadas (NER), que identifica nomes, lugares, datas, organizações, etc. A Figura 21 do estudo mostra uma correlação muito forte entre o uso de LLMs e a quantidade de NERs em uma redação. O grupo LLM usou quase o dobro de NERs que o grupo de busca e significativamente mais que o grupo Apenas Cérebro.

Este gráfico de barras mede a força da associação entre o grupo e o uso de NERs. O valor de Cramer's V varia de 0 (sem associação) a 1 (associação perfeita). O grupo LLM (em vermelho) apresenta um valor muito mais alto, indicando que a presença de um LLM era um forte preditor do uso de muitas entidades nomeadas. Os grupos Search Engine (verde) e Brain Only (azul) mostram uma associação moderada e fraca, respectivamente.

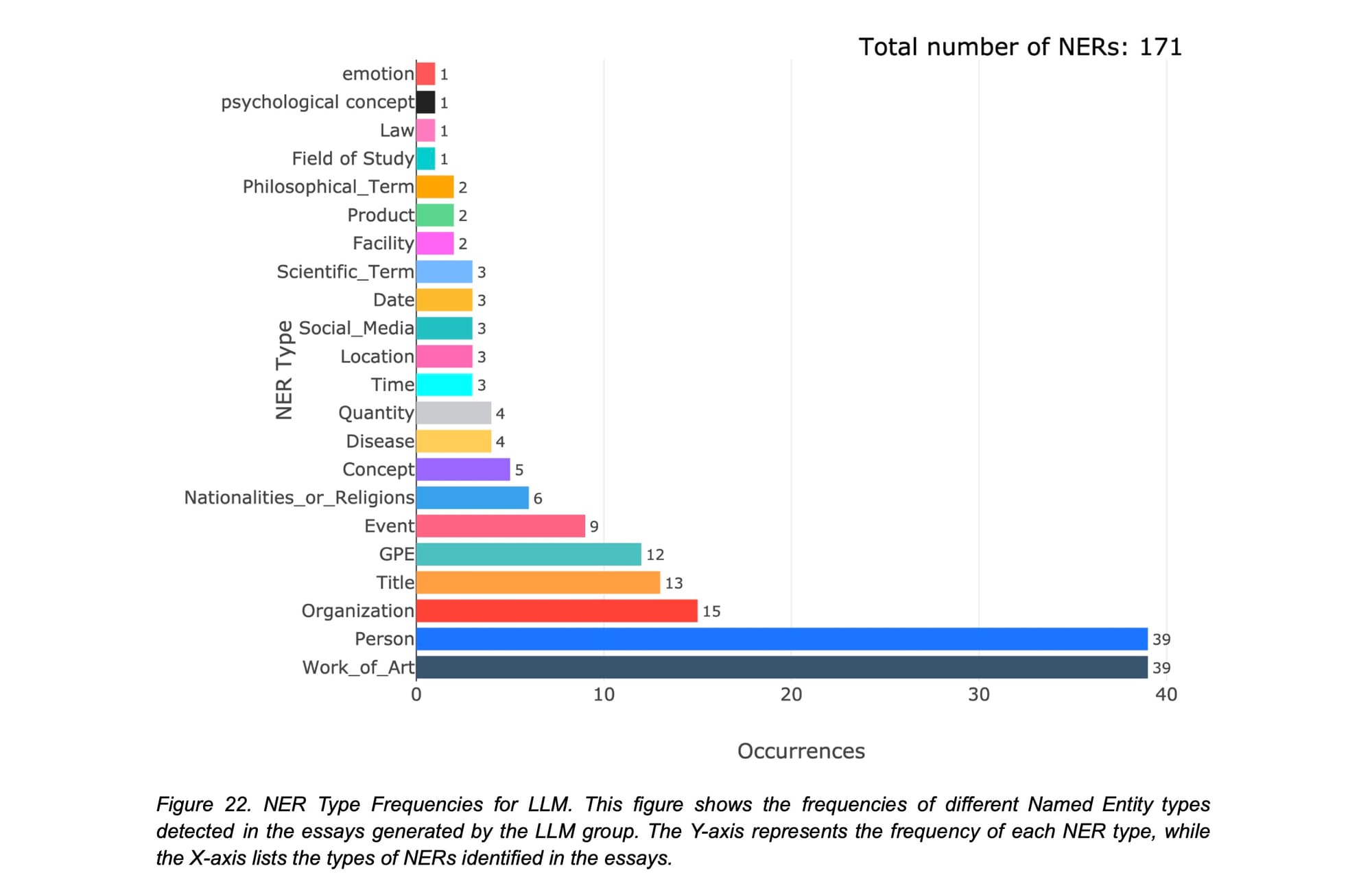

Mas que tipo de entidades eram essas? As Figuras 22, 23 e 24 detalham isso. O grupo LLM (Figura 22) encheu suas redações com referências a "Obras de Arte" e "pessoas", citando nomes como o filósofo Paulo Freire e Platão. Isso cria uma fachada de erudição, mas, como veremos, essa erudição é muitas vezes superficial e homogênea. O grupo de Search Engine (Figura 23) usou termos mais comuns como "regra de ouro" e "homo sapiens", refletindo uma pesquisa mais orgânica e menos direcionada. O grupo Apenas Cérebro (Figura 24), por sua vez, teve uma distribuição mais uniforme, com um pico interessante em "Mídia Social" (como "Instagram"), mostrando a influência de suas próprias experiências e contexto cultural.

O que isso nos diz? O uso do LLM levou a textos que, na superfície, parecem mais "inteligentes" e bem-pesquisados, mas essa é uma inteligência emprestada e padronizada. Os textos do grupo LLM eram estatisticamente muito semelhantes entre si dentro de um mesmo tópico, quase como se todos tivessem bebido da mesma fonte – e, de fato, beberam. Isso aponta para um risco real de homogeneização do pensamento e da escrita.

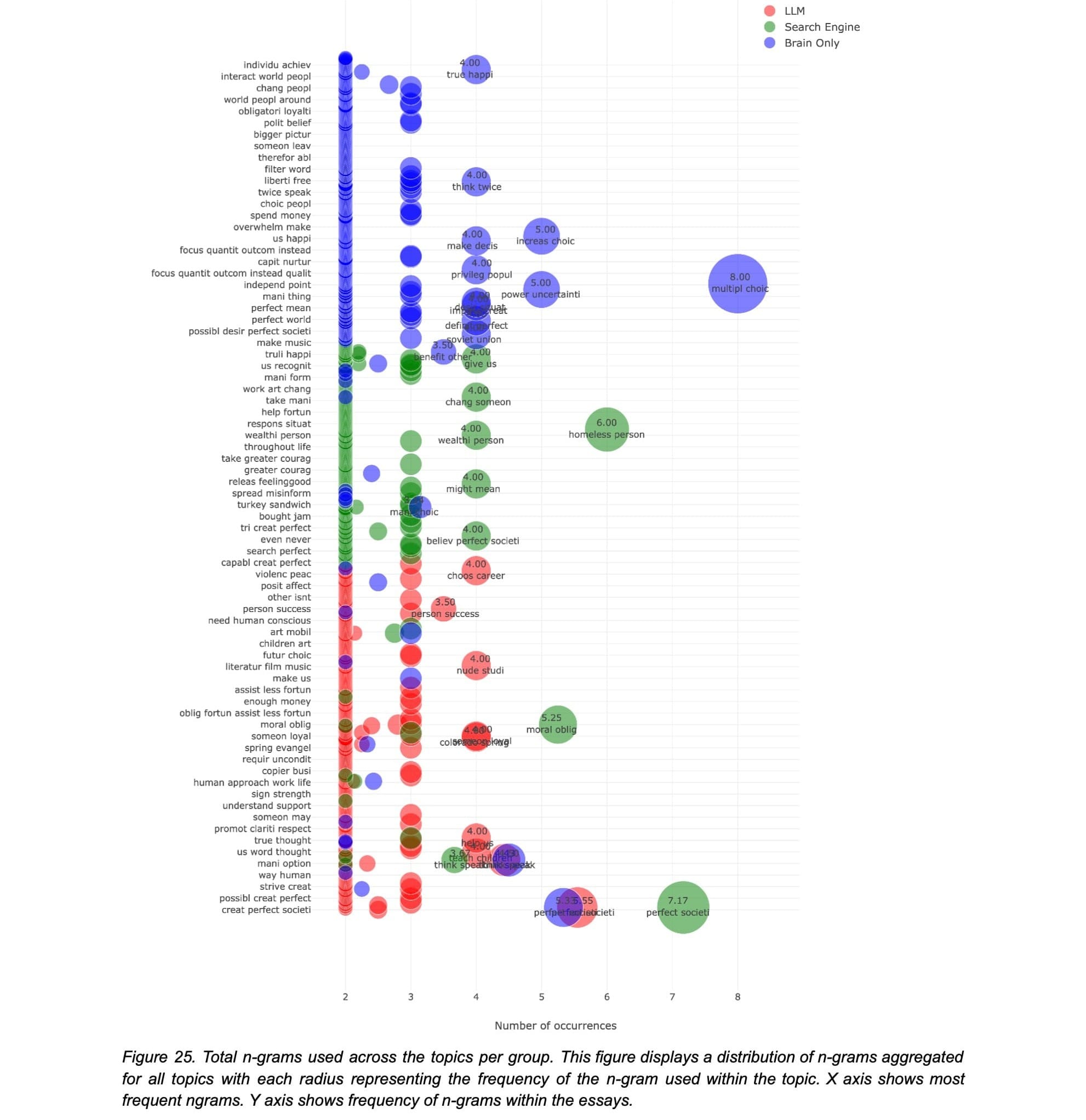

A "impressão digital" da escrita: análise de N-grams e ontologias

A análise de n-grams (sequências de palavras) aprofundou essa percepção. A Figura 25 acima mostra um panorama geral dos n-grams mais frequentes. Enquanto frases como "sociedade perfeita" aparecem em todos os grupos (afinal, era um dos temas), o grupo Apenas Cérebro se destacou com frases únicas como "múltiplas escolhas" e "poder da incerteza", refletindo um pensamento mais original. O grupo de busca foi influenciado por termos de pesquisa otimizados, como "pessoa sem-teto", e o grupo LLM, por sua vez, mostrou uma mistura que carecia de uma assinatura clara.

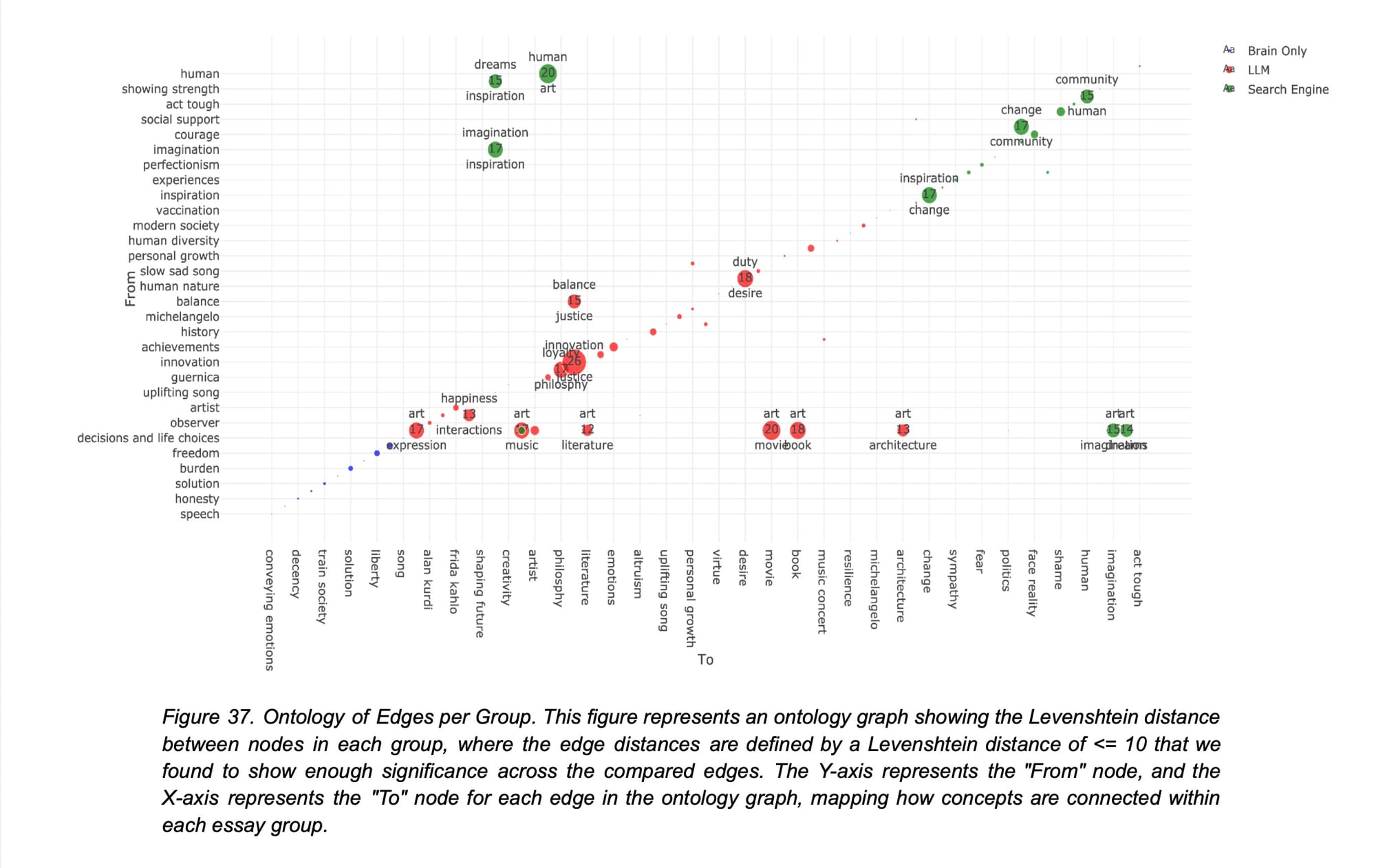

A análise mais sofisticada, no entanto, veio da criação de "ontologias" para cada redação. Pense nisso como um mapa conceitual que mostra como as ideias se conectam. Usando um agente de IA para gerar esses grafos, os pesquisadores visualizaram as estruturas de pensamento de cada grupo.

A Figura 37 é talvez uma das mais impactantes do estudo. Ela mostra a sobreposição das conexões conceituais (arestas do grafo) entre os grupos. O resultado é gritante: há uma sobreposição massiva entre os grupos LLM (vermelho) e Search Engine (verde), especialmente em torno de conceitos como "justiça", "inovação" e "arte". Seus mapas conceituais eram notavelmente semelhantes. Em contraste, o grupo Apenas Cérebro (azul) está quase isolado no gráfico. Suas conexões conceituais, como "liberdade -> liberdade" ou "fardo -> solução", eram únicas e não se cruzavam significativamente com as dos outros grupos.

Isso sugere que os participantes que usaram apenas seus cérebros construíram argumentos a partir de uma base de conhecimento e uma estrutura de pensamento verdadeiramente pessoal e original. Os outros dois grupos, mesmo o de busca, foram empurrados para uma forma de pensar mais padronizada, moldada pelos algoritmos da ferramenta que estavam usando, seja o ranking do Google ou os dados de treinamento do ChatGPT.

O que o EEG revelou sobre a conectividade cerebral

Esta é a parte mais profunda e, para nós, da área de tecnologia, a mais emocionante do estudo. O que realmente acontece no cérebro quando interagimos com essas diferentes ferramentas? Os dados de EEG, analisados através de uma técnica sofisticada chamada Função de Transferência Direta Dinâmica (dDTF), que mede como diferentes áreas do cérebro se influenciam mutuamente, revelaram padrões radicalmente diferentes entre os grupos.

Em resumo, o estudo encontrou uma escala clara e consistente: a conectividade cerebral diminuía sistematicamente com a quantidade de suporte externo. O grupo Apenas Cérebro exibiu as redes neurais mais fortes e abrangentes; o grupo Mecanismo de Busca mostrou um engajamento intermediário; e o grupo LLM provocou o acoplamento geral mais fraco. Vamos detalhar isso por banda de frequência cerebral.

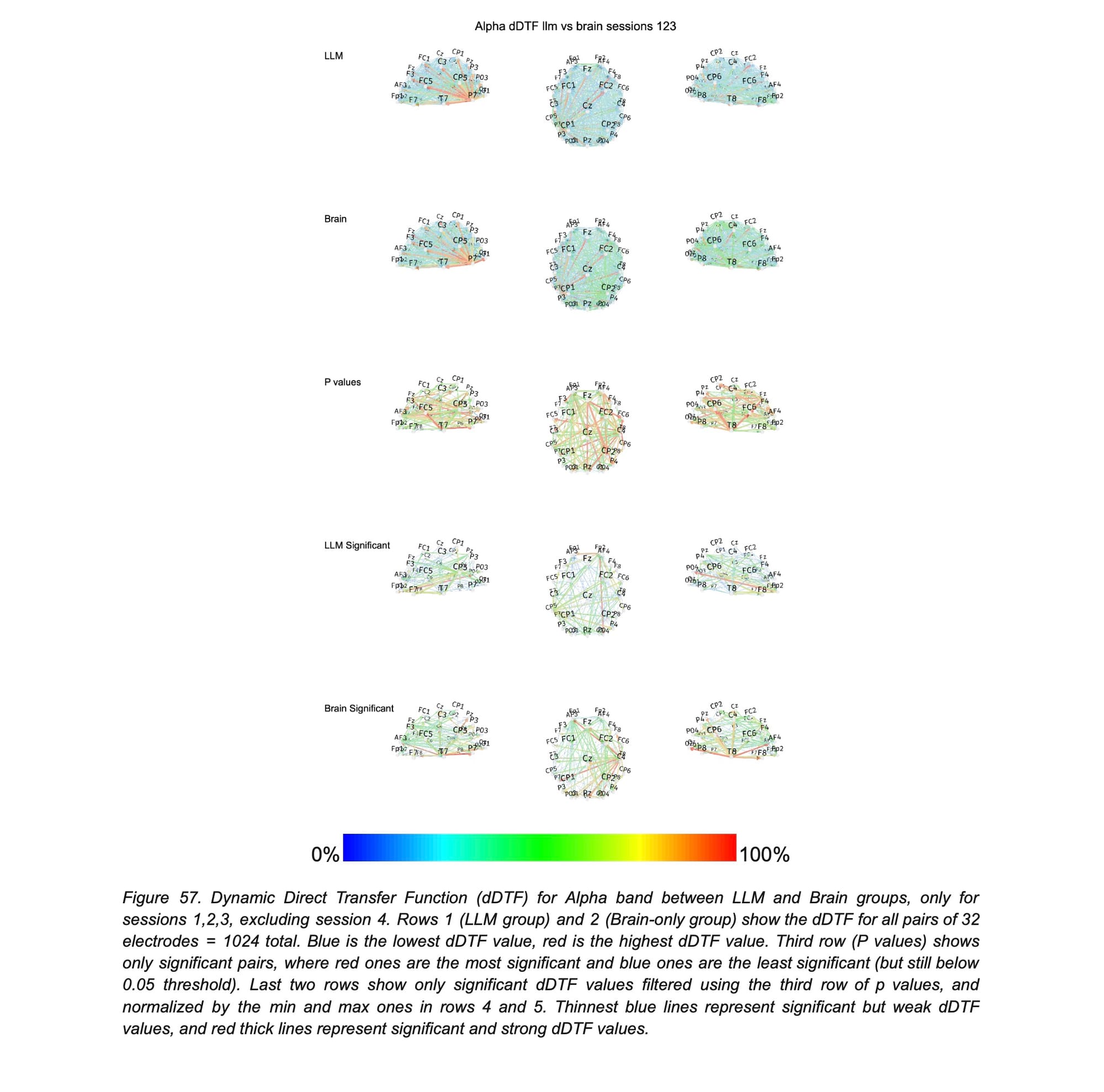

Ondas alfa (8-12 Hz): o motor da reflexão interna

As ondas Alfa estão frequentemente associadas à atenção interna, ao processamento semântico e à ideação criativa. É o estado cerebral que ativamos quando fechamos os olhos para lembrar de algo ou quando estamos imersos em um devaneio criativo.

A Figura 57 do estudo mostra as diferenças na conectividade Alfa, e elas são drásticas. O grupo Apenas Cérebro (segunda linha) mostra uma rede de conexões significativamente mais forte e densa do que o grupo LLM (primeira linha). Conexões críticas, como a do lobo parietal esquerdo (P7) para o temporal direito (T8) – uma via essencial para o processamento semântico – foram altamente significativas e muito mais fortes no grupo Apenas Cérebro. Eles também mostraram um fluxo de informação mais intenso das áreas occipitais (visuais) para as frontais (executivas).

O que isso significa? Escrever sem ajuda externa forçou o cérebro a um estado de maior processamento interno. Os participantes tiveram que gerar, combinar e estruturar ideias a partir de sua própria memória, um processo que exige uma intensa comunicação entre as redes semânticas e executivas do cérebro. O cérebro deles estava, literalmente, "trabalhando mais" no processo criativo. Em contrapartida, o grupo LLM, ao receber sugestões prontas, pode ter terceirizado parte desse esforço criativo, resultando em uma conectividade Alfa visivelmente menor.

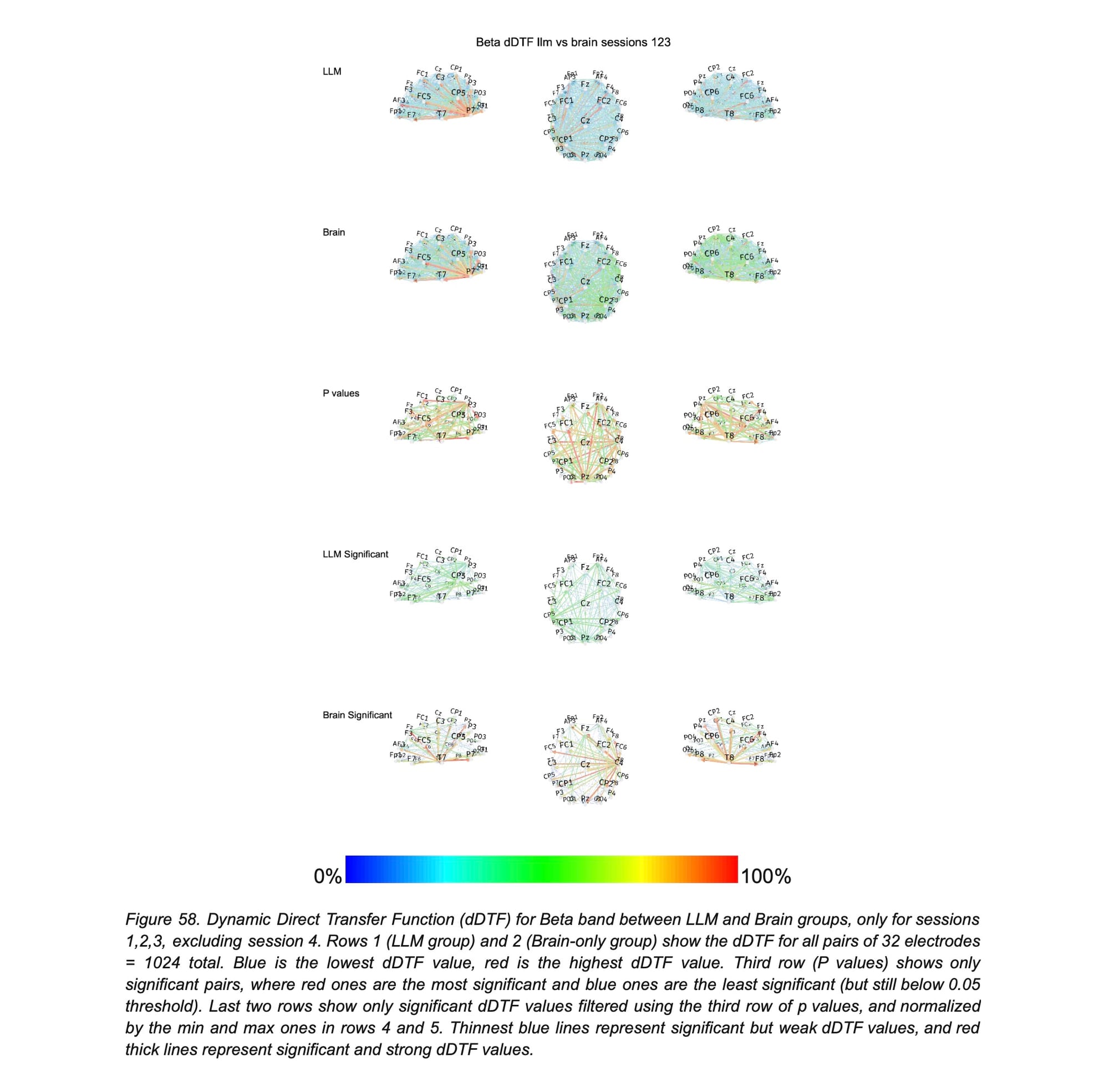

Ondas beta (12-30 Hz): o ritmo do foco e da ação

As ondas Beta estão ligadas ao processamento cognitivo ativo, à atenção focada e à integração sensório-motora. A Figura 58 mostra que, novamente, o grupo Apenas Cérebro manteve uma conectividade superior, especialmente em conexões do lobo temporal para o frontal (P7->T8). Isso reflete um engajamento cognitivo e motor sustentado. Escrever sem uma ferramenta exige que se mantenha o plano da redação, gere o texto continuamente e execute a ação de digitar, processos que se manifestam em oscilações Beta. O grupo LLM não apresentou nenhum aumento em conexões Beta em relação ao grupo Apenas Cérebro, sugerindo um esforço de concentração geral menor.

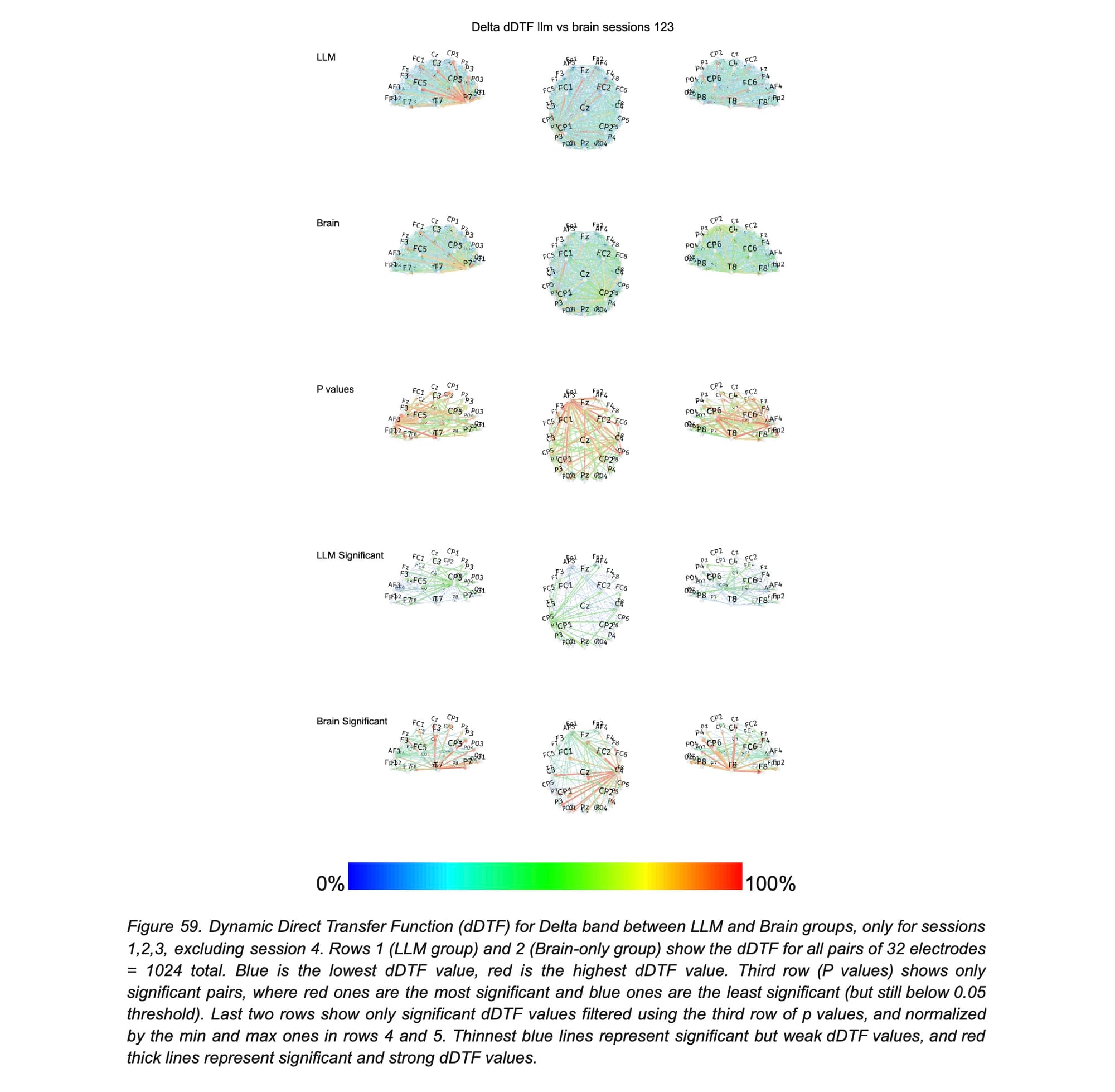

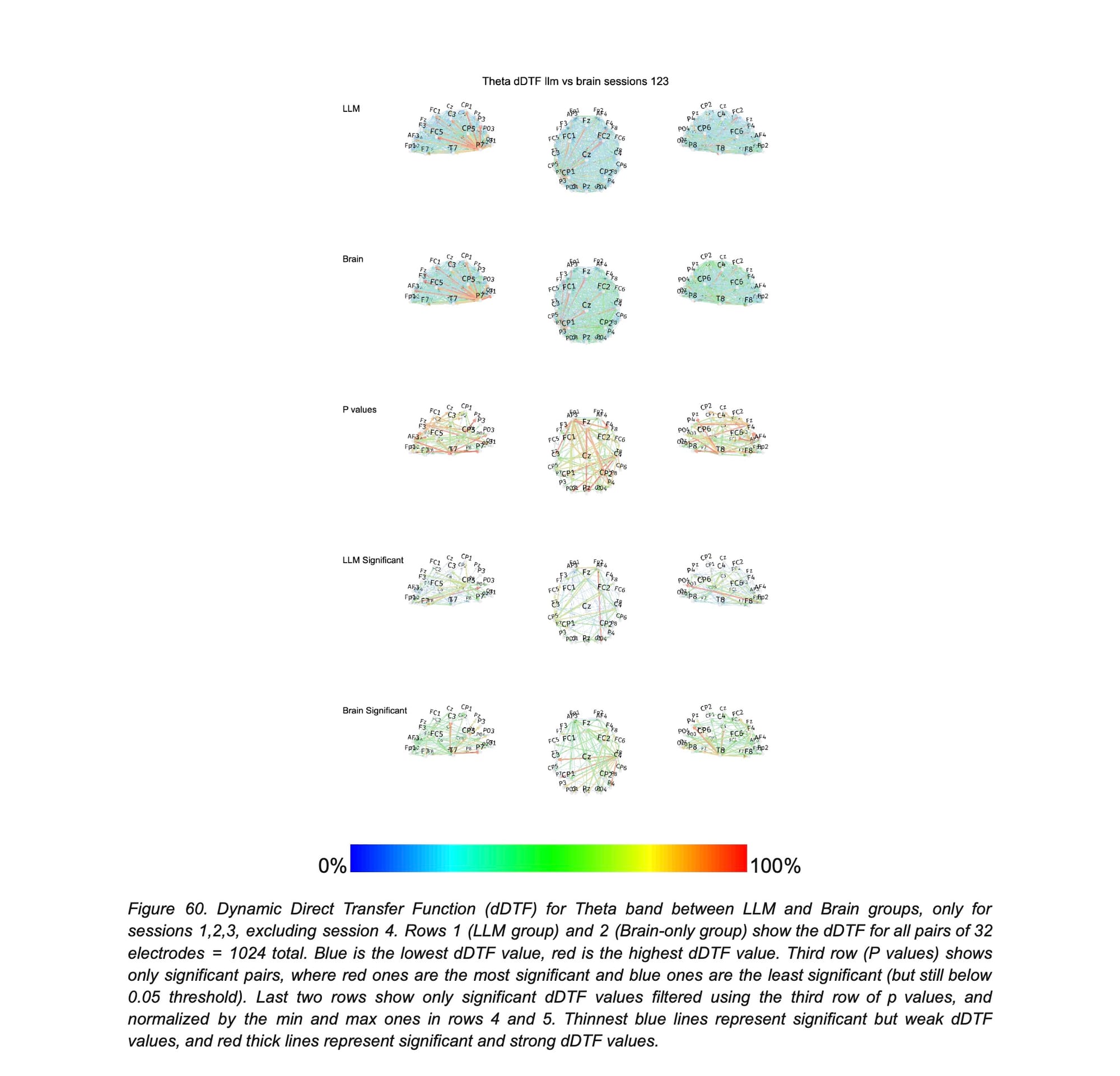

Ondas delta (0.1-4 Hz) e theta (4-8 Hz): as ondas da carga cognitiva e da memória

As ondas de baixa frequência, Delta e Theta, contam uma história semelhante, mas ainda mais pronunciada. As ondas Delta estão relacionadas à integração cortical em larga escala e à atenção de alto nível. A Figura 59 mostra o domínio esmagador do grupo Apenas Cérebro, com 78 conexões significativamente mais fortes contra apenas 31 para o grupo LLM. A região frontal anterior (AF3) emergiu como um grande centro de convergência para o grupo Apenas Cérebro, indicando um intenso engajamento do controle executivo. Isso sugere que a escrita não assistida recruta redes neurais distribuídas muito mais amplamente, possivelmente refletindo uma imersão mais profunda no pensamento interno e na integração multissensorial e de memória.

As ondas Theta são um marcador clássico da carga da memória de trabalho e do controle executivo. Quanto mais informações você precisa manter e manipular em sua mente, mais fortes são suas ondas Theta. A Figura 60 revela que o grupo Apenas Cérebro teve uma conectividade Theta muito mais extensa (65 conexões significativas vs. 29 para o grupo LLM). As conexões fronto-parietais, especialmente, eram muito mais fortes, indicando que o cérebro estava sob uma carga cognitiva maior para coordenar ideias, estruturas linguísticas e atenção em tempo real. O grupo LLM, por outro lado, com sua conectividade Theta significativamente menor, parece ter descarregado essa carga de memória de trabalho na ferramenta, que forneceu um "andaime" externo para o processo de escrita.

A 4ª sessão: A dívida cognitiva se torna visível

Se os resultados das três primeiras sessões já são reveladores, a análise da quarta sessão, onde os grupos foram trocados, é onde a hipótese da "dívida cognitiva" realmente se cristaliza.

- De LLM para Apenas Cérebro (LLM-to-Brain): Quando os participantes que estavam acostumados a usar o ChatGPT tiveram que escrever apenas com seus cérebros, sua conectividade neural não retornou ao nível de um novato, mas também não alcançou o nível de um praticante experiente do grupo Apenas Cérebro. Sua conectividade nas bandas Alfa e Beta, cruciais para o raciocínio crítico e a geração de ideias, foi significativamente menor do que os picos vistos no grupo Apenas Cérebro. Isso é um forte indício de atrofia de habilidade. Por terem terceirizado o planejamento e a geração de conteúdo para a IA nas sessões anteriores, eles não "exercitaram" essas redes neurais da mesma forma. Quando a "muleta" da IA foi removida, seu cérebro demonstrou um esforço neural menos coordenado, especialmente nos processos de pensamento de alta ordem.

- De Apenas Cérebro para LLM (Brain-to-LLM): O resultado oposto foi ainda mais surpreendente. Quando os participantes que só usaram o cérebro ganharam acesso ao LLM, sua conectividade cerebral disparou, superando a dos usuários habituais de LLM. Por quê? Porque eles estavam realizando uma tarefa duplamente complexa: continuavam a executar seus processos internos de pensamento e geração de ideias, mas agora tinham que adicionar a tarefa de avaliar, filtrar e integrar as sugestões externas da IA. Isso reativou amplamente os nós occipito-parietais e pré-frontais, em um padrão que se assemelha ao do grupo Mecanismo de Busca, mas com ainda mais intensidade.

Esses resultados pintam um quadro claro: o uso contínuo de LLMs pode levar a uma dependência que enfraquece nossa capacidade de pensar de forma independente. A conveniência tem um custo neurológico.

O veredito: memória, autoria e a percepção humana

Os dados neurais ganham ainda mais força quando correlacionados com os resultados comportamentais, coletados através das entrevistas pós-tarefa e da avaliação das redações por professores humanos e por um "juiz de IA".

A incapacidade de lembrar: o efeito mais chocante

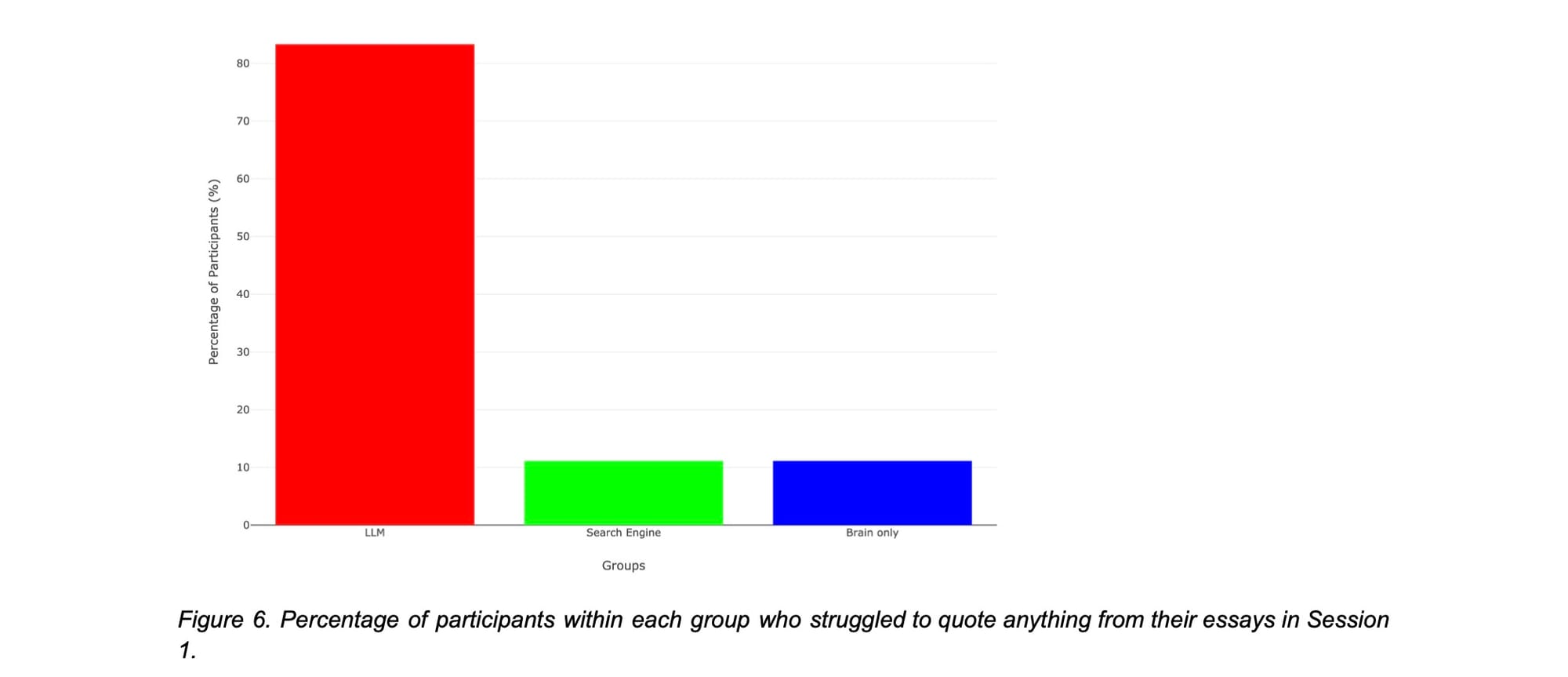

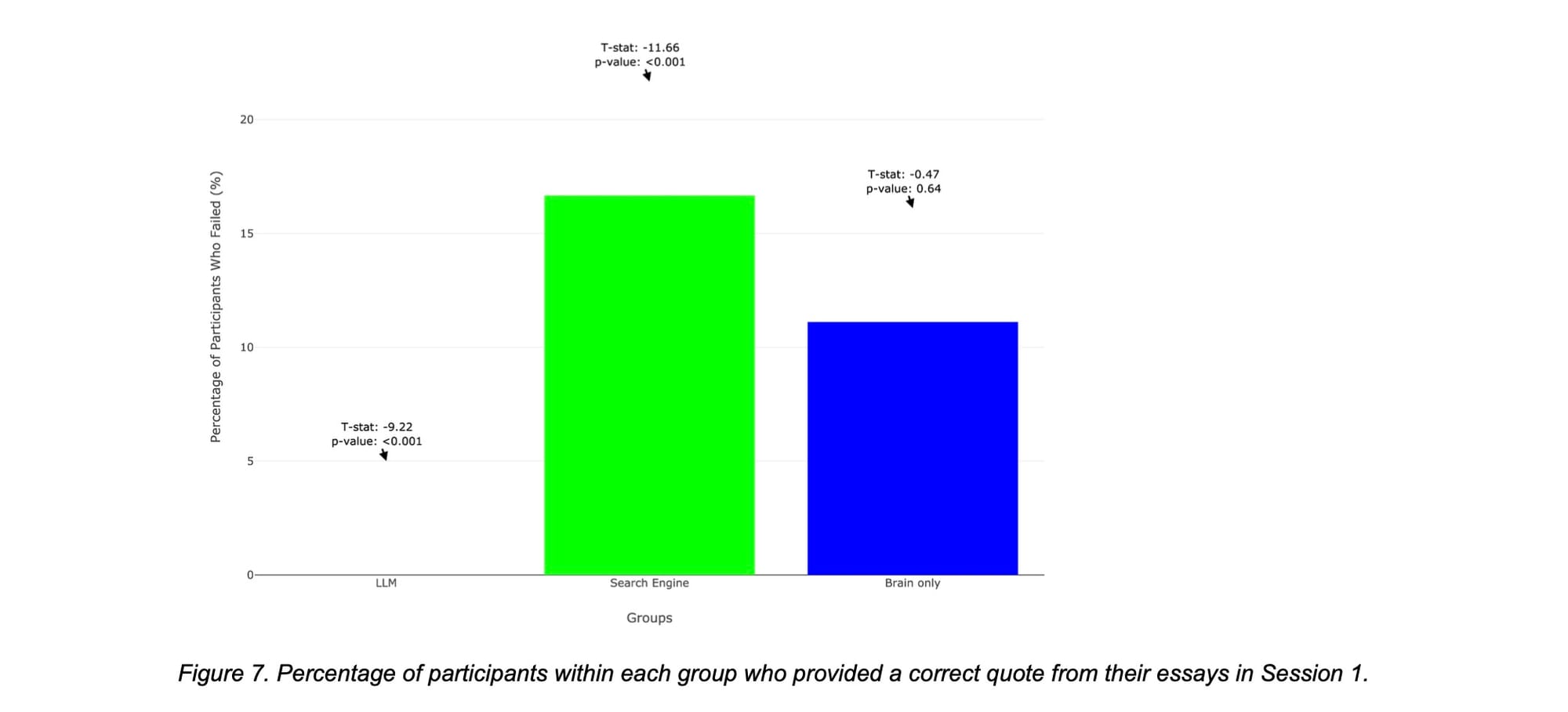

A descoberta mais consistente e alarmante foi a diferença na capacidade dos participantes de citar suas próprias redações minutos após escrevê-las. As Figuras 6 e 7 do estudo são categóricas.

- Na primeira sessão, 83% dos usuários de LLM (15 de 18) não conseguiram citar uma única frase de sua redação, e nenhum deles conseguiu fornecer uma citação correta.

- Em contraste, apenas 11% dos participantes dos grupos Apenas Cérebro e Mecanismo de Busca tiveram a mesma dificuldade.

Este é o reflexo comportamental direto da baixa conectividade Alfa e Theta observada nos EEGs do grupo LLM. O processamento da informação foi tão superficial que o conteúdo não foi devidamente codificado na memória episódica. Eles selecionaram e transcreveram texto gerado externamente sem a integração profunda necessária para a recordação. É como ler um texto sem prestar atenção – as palavras passam pelos olhos, mas não deixam vestígios na mente.

Quem é o dono do texto? A crise de autoria

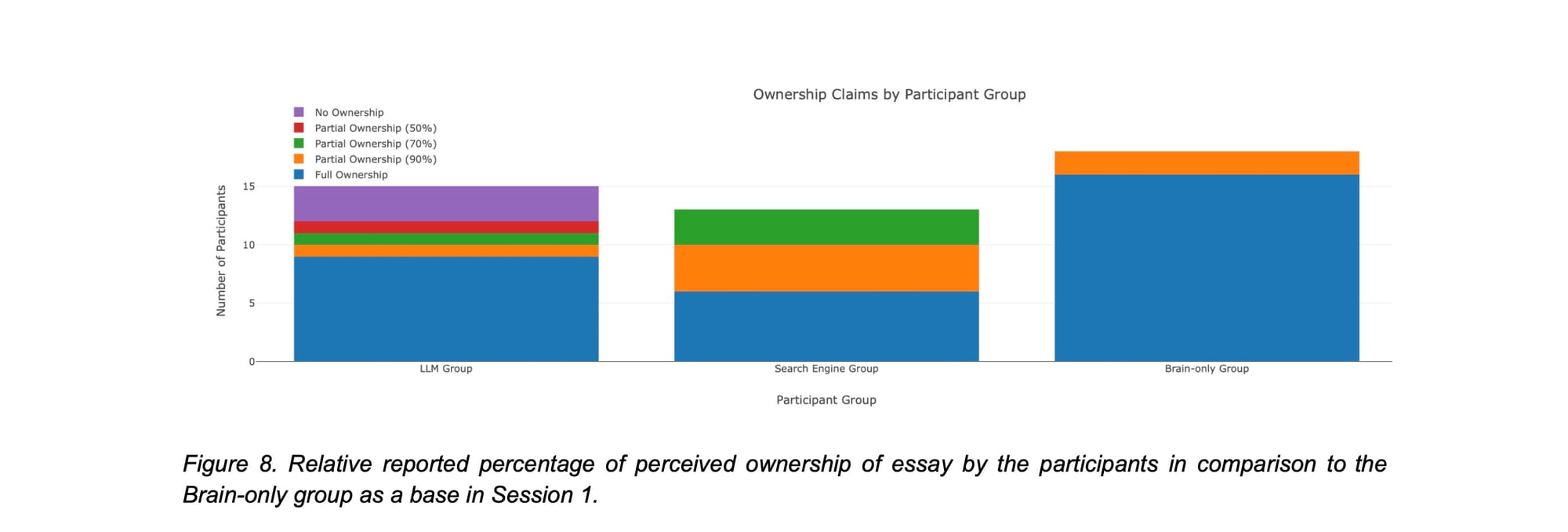

A percepção de autoria também variou drasticamente. A Figura 8 ilustra isso: o grupo Apenas Cérebro reivindicou posse total de suas redações de forma quase unânime. O grupo LLM, no entanto, mostrou uma visão fragmentada: alguns reivindicaram posse total, outros negaram completamente, e muitos se atribuíram um crédito parcial (50%, 70%, 90%).

Essa dissociação psicológica do resultado de seu trabalho é um sintoma da terceirização cognitiva. A reduzida ativação das regiões frontais anteriores, responsáveis pela autoavaliação e monitoramento de erros, no grupo LLM, explica essa sensação de agência diminuída. Se o trabalho pesado de pensar e criar é feito pela máquina, como podemos sentir que o trabalho é realmente nosso?

Juízes humanos vs. Juiz de IA: A percepção da "Alma"

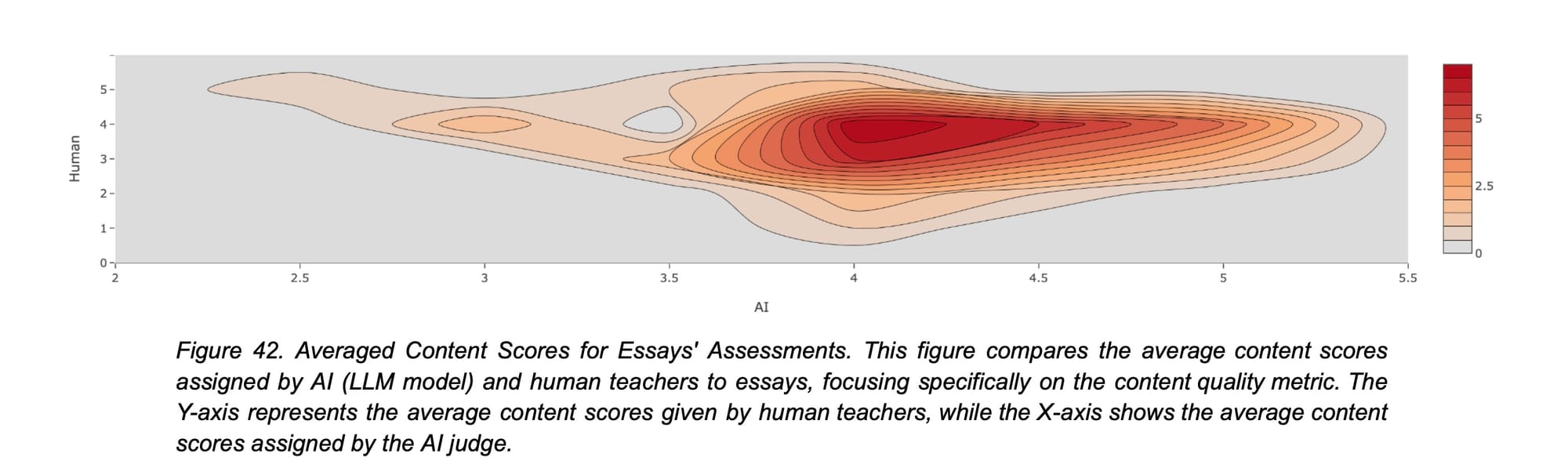

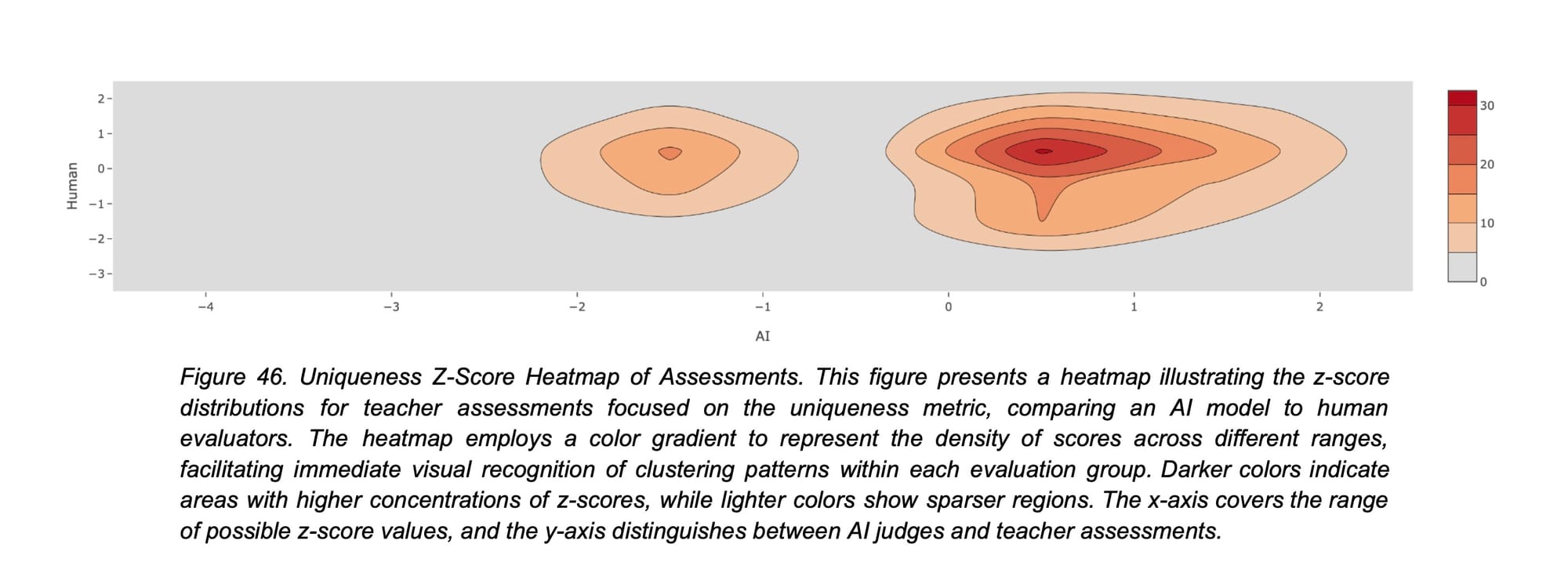

A avaliação das redações trouxe uma camada final de ironia e profundidade. Os pesquisadores pediram a dois professores de inglês experientes e a um "juiz de IA" (um LLM ajustado para avaliar textos) que pontuassem as redações em métricas como conteúdo, estrutura, precisão e, crucialmente, "singularidade" (uniqueness).

Os professores humanos, sem saberem da existência dos grupos, rapidamente perceberam um padrão. Eles descreveram muitas redações como "sem alma" e "robóticas", notando que, embora fossem gramaticalmente perfeitas e bem estruturadas, careciam de nuances pessoais e continham ideias clichês e recorrentes. Eles valorizaram a "individualidade e a criatividade acima da 'perfeição' objetiva". Como resultado, eles frequentemente deram notas mais baixas de conteúdo e singularidade para os textos que, sem saber, vinham do grupo LLM.

O juiz de IA, por outro lado, foi muito menos cético. A Figura 42 mostra que o juiz de IA (eixo X) tendeu a dar notas altas de conteúdo (acima de 4), enquanto os humanos (eixo Y) deram notas muito mais variadas e frequentemente mais baixas para as mesmas redações. Na Figura 46, que foca na métrica de singularidade, a divergência é ainda mais clara: há um grande cluster de redações que o juiz de IA considerou acima da média em singularidade, enquanto os professores as classificaram como abaixo da média.

A IA, em sua forma atual, parece ser boa em imitar a estrutura e o vocabulário de uma escrita de qualidade, mas falha em replicar (e em reconhecer) a profundidade, a originalidade e a "alma" que vêm do pensamento humano genuíno. Os professores humanos, com sua experiência, conseguiram "sentir" a falta de esforço cognitivo e de engajamento pessoal.

Isso reforça, como eu disse neste texto, o motivo de detectores textuais de IA serem uma farsa e não serem capaz de distinguir um texto bem escrito de um gerado por IA.

A dívida cognitiva: O custo oculto da conveniência e a nossa responsabilidade

Ao sintetizar todas essas evidências – os textos homogêneos, a conectividade cerebral reduzida, a memória fraca e a autoria diluída –, o conceito de dívida cognitiva se torna terrivelmente claro. O estudo do MIT define-a como uma condição em que a confiança repetida em sistemas externos substitui os processos cognitivos trabalhosos necessários para o pensamento independente. Nós "pagamos" pela conveniência de curto prazo com uma moeda de longo prazo: a diminuição da nossa capacidade de investigação crítica, o aumento da nossa vulnerabilidade à manipulação e o enfraquecimento da nossa criatividade.

Os participantes que usaram LLMs, especialmente aqueles que começaram com a ferramenta, não apenas produziram um trabalho menos original, mas também demonstraram um engajamento neural mais fraco. Quando a ferramenta foi retirada, eles lutaram para realizar a tarefa de forma independente com o mesmo nível de proficiência neural que aqueles que praticaram sem ajuda. Eles acumularam uma dívida, e a hora de pagar chegou na quarta sessão.

Para nós, profissionais de TI, programadores e arquitetos do mundo digital, essas descobertas não são apenas um alerta; são um chamado à ação. Estamos construindo as ferramentas que moldarão o futuro do pensamento humano. O estudo sugere que o caminho a seguir não é a rejeição, mas a integração estratégica e consciente.

O que isso significa na prática?

- Design de ferramentas centrado no humano: Precisamos projetar sistemas de IA que atuem como verdadeiros colaboradores, não como substitutos. Ferramentas que façam perguntas, que desafiem o usuário, que incentivem a reflexão e que talvez até se recusem a dar respostas prontas, podem ser mais benéficas a longo prazo do que aquelas que simplesmente entregam o produto final.

- Educação e alfabetização em IA: Assim como aprendemos a usar calculadoras sem perder a capacidade de fazer matemática básica, precisamos aprender a usar LLMs de forma crítica. Isso envolve entender seus vieses, suas limitações e, crucialmente, saber quando desligá-los e pensar por conta própria. O estudo sugere que um modelo educacional que adia a integração da IA até que os alunos tenham desenvolvido um esforço cognitivo autodirigido suficiente pode promover tanto a eficácia imediata da ferramenta quanto a autonomia cognitiva duradoura.

- Uso consciente e híbrido: Talvez a abordagem mais poderosa, como sugerido pelos resultados do grupo Brain-to-LLM, seja um modelo híbrido. Usar nosso próprio cérebro para a ideação, o rascunho e o pensamento crítico inicial, e depois usar a IA como uma parceira de sparring para refinar, verificar e expandir nossas ideias. Isso parece engajar o cérebro de forma mais completa e complexa, aproveitando o melhor dos dois mundos.

O estudo do MIT não é uma condenação da inteligência artificial. É um mapa detalhado e baseado em evidências dos seus efeitos no nosso órgão mais vital. Ele nos mostra que, embora as IAs possam nos oferecer respostas rápidas, elas não podem nos dar o entendimento que vem do esforço, da luta e da descoberta pessoal. A conveniência é sedutora, mas a dívida cognitiva é real. Como construtores do futuro, temos a responsabilidade de garantir que as máquinas que criamos sirvam para nos libertar, e não para, silenciosamente, nos escravizar a uma forma de pensar mais pobre e menos humana.

Se você também é da área de TI pode se interessar sobre este post onde destrinchei outro artigo para falar da capacidade da IA de resolver problemas de computação.

Se quiser ler o artigo deste post, inteiro na íntegra, pode acessá-lo abaixo:

Comments