A fraude dos detectores textuais de IA

TecnologiaÉ necessário questionar, com base em evidências reais, se esses detectores realmente cumprem o que prometem ou se não passam de fraudes sofisticadas explorando o medo das instituições e usuários para vender planos premium.

O avanço das inteligências artificiais generativas, principalmente os grandes modelos de linguagem (LLMs, em inglês), como ChatGPT, GPT-4 e diversos outros, trouxe novas preocupações sobre autenticidade e originalidade dos conteúdos produzidos. Esse temor gerou rapidamente um mercado fértil para ferramentas que afirmam ser capazes de detectar conteúdos gerados por IA. Contudo, é necessário questionar, com base em evidências reais, se esses detectores realmente cumprem o que prometem ou se não passam de fraudes sofisticadas explorando o medo das instituições e usuários para vender planos premium.

Em uma análise recente e detalhada, decidi testar algumas das principais ferramentas que prometem detectar conteúdo gerado por IA. A metodologia foi direta: selecionei seis textos distintos, sendo três claramente produzidos por ferramentas de IA, como o ChatGPT, e três comprovadamente escritos por seres humanos. Dos textos humanos, dois eram trabalhos acadêmicos publicados em 2011 e 2014—muito antes do surgimento dos LLMs modernos—e o terceiro era um texto escrito por mim pessoalmente, com autenticidade absoluta garantida.

As ferramentas testadas foram Justdone, Grammarly, Quillbot, Scribbr, Copyleaks, Phrasly e NoteGPT. O resultado foi não apenas decepcionante, mas também escandaloso.

Resultados do teste

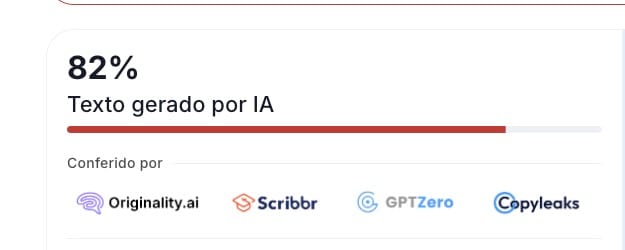

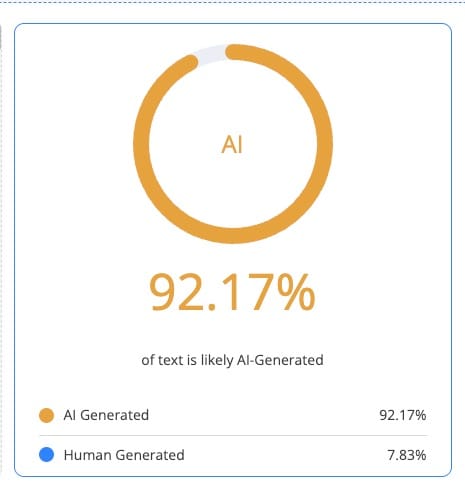

Os resultados foram alarmantes pela sua inconsistência e ineficácia. Justdone classificou os textos claramente humanos com índices entre 75% e 91% de "conteúdo gerado por IA". Isso significa que textos genuínos, produzidos antes mesmo da existência dos modelos atuais, foram taxados erroneamente como artificiais.

Grammarly, embora aparentemente mais preciso em alguns casos (com uma identificação correta de 0% de IA em um dos textos humanos), ainda falhou significativamente nos outros dois textos humanos, marcando-os com índices de 4% e 9%. Se o objetivo da ferramenta é diferenciar claramente o artificial do humano, qualquer margem de erro já é suficiente para desacreditá-la como confiável.

Quillbot apresentou resultados absurdamente altos, indicando entre 65% e 92% de probabilidade de IA em textos humanos. Da mesma forma, Scribbr oscilou bastante, entre 45% e 85%, evidenciando uma variabilidade que não pode ser considerada sequer minimamente confiável.

Copyleaks, talvez a menos problemática entre as testadas, identificou corretamente dois textos humanos com 0% de IA. Contudo, mesmo assim, um dos textos claramente humanos foi erroneamente identificado como tendo 5% de conteúdo artificial. Embora pareça um percentual baixo, em contextos acadêmicos ou de negócios, qualquer falsa acusação já poderia ter consequências sérias.

Phrasly também foi inconsistente, marcando textos humanos com índices entre 61% e 79%. E NoteGPT, por sua vez, foi a mais desastrosa, com índices absurdos de 88% a 94% para textos comprovadamente humanos. Esses resultados são simplesmente injustificáveis e levantam sérias dúvidas sobre a integridade desses serviços.

Por que essas ferramentas falham?

A falha dessas ferramentas não está relacionada apenas à qualidade dos algoritmos, mas ao princípio fundamental sobre como os modelos de linguagem funcionam. Os detectores baseiam-se em padrões estatísticos que assumem uma previsibilidade na estrutura e estilo textual gerado por IAs. No entanto, esses modelos estão constantemente evoluindo, gerando textos cada vez mais naturais e complexos. Simultaneamente, textos humanos podem, por razões estilísticas, técnicas ou acadêmicas, também apresentar padrões semelhantes aos identificados pelas IAs.

Essa sobreposição de características torna praticamente impossível que os detectores distingam com certeza absoluta conteúdos gerados por humanos ou máquinas. Ademais, textos acadêmicos mais antigos apresentam padrões rígidos que muitas vezes são confundidos erroneamente com conteúdo artificial pelas ferramentas atuais.

O mais absurdo, é que em alguns testes o texto gerado por uma IA teve nota menor que um texto gerado por humano. Não há qualquer possibilidade de levar essas ferramentas a sério.

A exploração comercial e ética

O mais preocupante é o aspecto comercial por trás dessas ferramentas. As empresas desenvolvedoras desses detectores estão vendendo planos premium sob a promessa ilusória de uma capacidade quase mágica de identificar textos artificiais. O resultado? Instituições educacionais, empresas e usuários individuais pagando por serviços que simplesmente não entregam o prometido.

Esta situação levanta importantes questões éticas. Vender uma solução baseada em um problema real, porém sem garantir resultados minimamente satisfatórios, pode ser visto como uma prática comercial desonesta e potencialmente fraudulenta. A indústria está explorando um medo crescente e legítimo para capitalizar lucros exorbitantes, enquanto entrega resultados altamente duvidosos.

Nos últimos anos, vimos casos emblemáticos de empresas tecnológicas que distorceram dados com a intenção de inflar a performance de seus produtos e enganar consumidores e investidores. Um exemplo recente envolve a Evolv Technologies, que comercializava detectores de armas supostamente “movidos a IA” com alegações exageradas de eficiência, incluindo a capacidade de ignorar itens inocentes e reduzir falsos alarmes em até 70 %. Contudo, investigações da FTC revelaram que os dispositivos nem sequer identificavam facas em escolas, enquanto disparavam alertas falsos para computadores e garrafas d’água.

Outro caso relevante é o da “AI washing”, prática em que empresas adicionam o termo “IA” em seus produtos sem nenhuma substância real por trás da promessa. Em 2024, a SEC impôs sanções a pelo menos duas gestoras por afirmarem falsamente utilizarem IA em investimentos, expondo o vazio entre o que era anunciado e o que realmente entregavam . Essas corporações fizeram uso de buzzwords para criar a impressão de inovação e, com isso, aumentar sua atratividade no mercado financeiro, embora os sistemas fossem, na prática, programas genéricos sem inteligência real. O que vemos constantemente acontecer. Lembram do caso da Kodak?

Mais amplamente, o escândalo da Volkswagen em 2015 é talvez o exemplo corporativo mais contundente de falsificação para ganhar vantagem comercial. A fabricante instalou “defeat devices” em milhões de veículos, manipulando testes oficiais para mascarar níveis reais de poluentes — um crime que custou mais de US$ 33 bilhões em multas, recalls e ações judiciais . A lição é clara: enjoadas práticas obscuras motivadas por pressão por resultados acabam colocando em risco a reputação das empresas — e, muitas vezes, a segurança e o meio ambiente. Esses exemplos escancaram que a adoção de linguagem tecnológica, como “IA” ou “scanners inteligentes”, sem respaldo técnico robusto, pode ser apenas fachada para operações comerciais duvidosas e rentáveis, mas eticamente condenáveis.

O que podemos concluir?

A fraude dos detectores de IA precisa ser amplamente discutida e analisada criticamente. As evidências coletadas mostram claramente que essas ferramentas são incapazes de fornecer uma distinção confiável entre textos gerados por humanos e por inteligência artificial. Essa incapacidade não apenas desacredita o setor como um todo, mas também pode ter consequências práticas graves, desde acusações falsas de plágio até penalizações injustas em contextos acadêmicos e profissionais.

Instituições e usuários devem ter consciência crítica ao considerar o uso dessas ferramentas. Não podemos confiar cegamente em promessas comerciais sem uma validação científica rigorosa e transparente. Até que tais tecnologias demonstrem eficácia comprovada, devemos tratá-las com o ceticismo merecido.

É fundamental que se estabeleça uma discussão honesta sobre as limitações e riscos da aplicação desses detectores. Mais importante ainda, a indústria deve ser cobrada por mais transparência e responsabilidade na venda dessas soluções. É nosso papel como consumidores, educadores, pesquisadores e profissionais exigirmos um padrão muito mais alto de qualidade, evitando que práticas potencialmente fraudulentas prosperem à custa da nossa ingenuidade e confiança.

E nós, que conseguimos escrever um texto melhor, estruturado e coerente, ficaremos taxados de pessoas que utilizam IA para gerar conteúdo.

Comments